作者|Mohamed Fouda,AllianceDAO

編譯|Cecilia,bfrenz DAO

自從 ChatGPT 和 GPT-4 推出後不久,關於 AI 如何徹底改變包括 Web3 在內的一切的內容就層出不窮了。多行業的開發人員都表示,通過利用 ChatGPT 作為解決方案,生產力顯著提高了 50% 到 500%。比如作為開發人員的一個副手,自動執行任務,比如生成樣板代碼、進行單元測試、創建文檔、調試和檢測漏洞。

雖然本文將探討 AI 如何實現新的有趣的 Web3 用例,但更重要的是詮釋 Web3 和 AI 之間的互利關係。很少有技術有可能對 AI 的發展軌跡產生重大影響,Web3 就是其中之一。

AI賦能Web3的具體場景

1. 區塊鏈遊戲

為不會編程的遊戲玩家生成bot

像 Dark Forest 這種基於區塊鏈的遊戲創造了一種獨特的玩法,玩家可以通過開發和部署執行遊戲任務的"機器人"來獲得優勢。然而,這種新的玩法可能會使那些不懂編程的玩家感到被排除在外。不過,人工智能語言模型(LLM)的出現可能會改變這一狀況。通過理解區塊鏈遊戲的規則,然後利用這些規則創建能夠反映玩家策略的"機器人",而無需玩家自己編寫代碼。例如,項目如 Primodium 和 AI Arena 正在嘗試讓人類玩家和 AI 玩家一同參與遊戲,而無需編寫複雜的代碼。

用 bot戰鬥或下注

另一種鏈上游戲的可能性是完全自動化的人工智能玩家。在這種情況下,玩家本身就是一個人工智能代理,比如 AutoGPT,它使用人工智能語言模型(LLM)作為後端,並且可以訪問互聯網和可能的初始加密貨幣資金等外部資源。這些人工智能玩家可以參與類似機器人大戰的競猜遊戲。這將為投機和押注這些競猜結果的玩家提供一個市場。這樣的市場可能會催生出全新的遊戲體驗,既具有策略性又能夠吸引更廣泛的玩家群體,無論他們是否精通編程。

為鏈上游戲創建逼真的NPC環境

如今,許多遊戲往往在 NPC 方面表現較為單一,它們的行動有限,對遊戲進程的影響相對較小。然而,在人工智能和 Web3 的相互作用下,我們有可能創造出更引人入勝的 NPC 環境,從而顛覆遊戲的可預測性,使其變得更加有趣。其中一個關鍵的前提是引入更具吸引力的人工智能控制的 NPC。

然而,在創造逼真的NPC 環境時,我們面臨著一個潛在挑戰:如何引入富有意義的NPC動態,同時又能夠將與這些活動相關的吞吐量(每秒事務處理量,TPS)最小化。過高的NPC活動所需的TPS可能會導致網絡擁塞,影響到實際玩家的遊戲體驗。

通過這些新的玩法和可能性,區塊鏈遊戲正在朝著更加多樣化和包容性的方向發展,使更多類型的玩家都能夠參與進來,共同體驗遊戲的樂趣。

2. 去中心化社交媒體

在當今,去中心化社交(DeSo)平檯面臨一個挑戰,即相較於現有中心化平台,它們難以提供獨特的用戶體驗。然而,通過與AI 的無縫集成,我們可以為 Web 2 的替代方案帶來獨特的體驗。舉個例子,由 AI 管理的賬戶可以通過分享相關內容、評論帖子以及參與討論來吸引新用戶加入網絡。此外, AI 賬戶還能夠實現新聞聚合,匯總與用戶興趣相符的最新趨勢。這種整合 AI 的方法將為去中心化社交媒體平台帶來更多創新,吸引更多用戶的加入。

3. 去中心化協議的安全性和經濟設計測試

以基於 LLM 的AI 助理為基礎,我們有機會對去中心化網絡的安全性和經濟穩健性進行實際測試。這種代理能夠定義目標、創建代碼並執行這些代碼,從而為評估去中心化協議的安全性和經濟設計提供了新的視角。在這一過程中,AI 助理被引導去利用協議的安全性和經濟平衡。它首先可以檢查協議文檔和智能合約,找出潛在弱點。然後,它可以獨立競爭執行攻擊協議的機制,以最大化自身的收益。這一方法模擬了協議啟動後可能遇到的實際環境。通過這些測試結果,協議設計者可以檢查協議的設計並修補潛在的弱點。目前,只有像 Gauntlet 等專業公司具備為去中心化協議提供此類服務的技術技能。但是,通過對 LLM 進行 Solidity、 DeFi 機制以及以往利用機制等方面的培訓,我們期待 AI 助理能夠提供類似的功能。

4. 用於數據索引和指標提取的 LLM

雖然區塊鏈數據是公共的,但索引和提取有用見解始終是一個挑戰。某些參與者(如 CoinMetrics)專門從事索引數據和構建複雜指標以進行銷售,而其他參與者(如 Dune)則專注於對原始交易的主要組成部分進行索引,並通過社區貢獻來提取部分指標。近期 LLM 的進展顯示出,數據索引和指標提取可能會迎來革命。區塊鏈數據公司 Dune 已經認識到了這一潛在威脅,並宣布 LLM 路線圖包括 SQL 查詢解釋和基於 NLP 查詢的潛在組件。然而,我們預測 LLM 的影響將更深遠。一種可能性是基於 LLM 的索引,其中 LLM 模型能夠直接與區塊鏈節點交互,為特定指標的數據建立索引。初創公司 Dune Ninja 等已經開始探索基於 LLM 的創新數據索引應用程序。

5. 開發者加入新的生態系統

不同的區塊鍊網絡吸引開發者來構建應用程序。 Web3 開發者活動是評估生態系統成功的重要指標之一。然而,開發人員在開始學習和構建新生態系統時,常常會遇到支持方面的困難。生態系統已經通過專門的 Dev Rel 團隊投入數百萬美元,以支持開發人員在探索生態系統中更好地發展。在這個領域,新興的 LLM 展示了驚人的成就,它可以解釋複雜代碼、捕獲錯誤,甚至創建文檔。經過微調的 LLM 可以補充人類的經驗,從而顯著提高開發團隊的生產力。例如,LLM 可以用於創建文檔、教程,回答常見問題,甚至可以為黑客馬拉松中的開發人員提供樣板代碼或創建單元測試。這些都將有助於促進開發人員的積極參與,推動整個生態系統的成長。

6.改進 DeFi 協議

通過將 AI 融入 DeFi 協議的邏輯中,可以顯著提升眾多 DeFi 協議的性能。目前,將 AI 應用於 DeFi 領域的主要難題之一是在鏈上實施 AI 的成本較高。儘管可以在鏈下實現 AI 模型,但之前無法驗證模型的執行情況。然而,通過諸如 Modulus 和 ChainML 等項目,鏈下執行的驗證正逐漸變為現實。這些項目允許在鏈外執行機器學習模型,同時限制鏈上的成本開銷。在 Modulus的情況下,鏈上的費用僅用於驗證模型的零知識證明(ZKP)。而在 ChainML 的案例中,鏈上的成本是用於向去中心化 AI 執行網絡支付預言機費用。

以下是一些可能從 AI 集成中受益的DeFi使用案例:

-

AMM 流動性配置:例如,更新 Uniswap V3 的流動性範圍。通過整合人工智能,協議可以更加智能地調整流動性範圍,從而提高 AMM(自動做市商)的效率和收益。

-

清算保護與債務頭寸:結合鏈上和鏈下數據,可以實現更有效的清算保護策略,保護債務頭寸不受市場波動影響。

-

複雜的 DeFi 結構化產品:設計金庫機制時,可以依賴金融人工智能模型而不是固定策略。這樣的策略可能包括由人工智能管理的交易、貸款或期權,從而提高產品的智能性和靈活性。

-

先進的鏈上信用評分機制:考慮不同區塊鏈上不同錢包的情況,整合人工智能可以幫助構建更精確和全面的信用評分系統,從而更好地評估風險和機會。

通過利用這些 AI 集成的案例,DeFi 領域可以更好地適應不斷變化的市場需求,提高效率,降低風險,並為用戶創造更多價值。同時,隨著鏈下驗證技術的不斷發展,AI 在 DeFi 中的應用前景也將進一步拓展。

Web3 技術能夠幫助提升 AI 模型的能力

雖然現有 AI 模型已經展現出巨大的潛力,但在數據隱私、特有模型執行的公平性以及虛假內容的創建和傳播方面仍然面臨挑戰。在這些領域,Web3技術的獨特優勢可能發揮重要作用。

1. 為 ML 訓練創建專有數據集

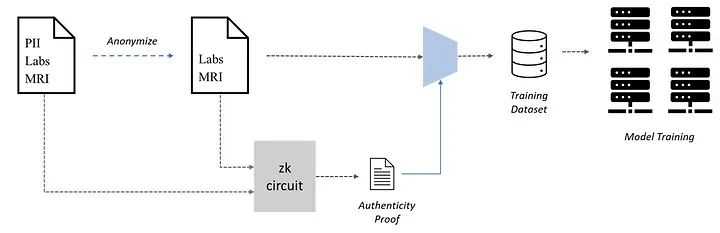

Web3 可以協助 AI 的領域之一是協作創建用於機器學習 (ML) 訓練的專有數據集,即用於數據集創建的 PoPW 網絡。海量數據集對於準確的ML 模型至關重要,但如何獲取這些數據,如何創建這些數據集可能會成為瓶頸,特別是在需要私有數據的用例中,比如使用ML 進行醫學診斷,圍繞患者數據的隱私問題構成了重大障礙,因為訓練這些模型需要訪問醫療記錄。然而,出於隱私考慮,患者可能不願分享他們的醫療記錄。為了解決這個問題,患者可以對他們的醫療記錄進行可驗證的匿名化處理,以保護他們的隱私,同時仍然可以在機器學習訓練中使用這些記錄。

然而,匿名處理後的數據的真實性可能令人擔憂,因為虛假數據可能會極大地影響模型性能。這時,零知識證明(ZKP)可以用來驗證匿名處理後的數據的真實性。患者可以生成ZKP,以證明匿名記錄確實是原始記錄的副本,即使在刪除個人身份信息(PII)後也是如此。這種方法既保護了隱私,又確保了數據的可信度。

2. 對私有數據運行推理

當前,大型語言模型(LLM)存在一個重要問題,即如何處理私有數據。舉例來說,當用戶與ChatGPT進行交互時,OpenAI會收集用戶的私有數據,並將其用於模型的訓練,從而引發敏感信息的洩露。近期的案例中,有員工在使用ChatGPT輔助辦公時不小心洩露了涉密數據,這使得這個問題更加突出。零知識(ZK)技術有望解決機器學習模型在處理私人數據時出現的問題。在這裡,我們將探討兩種場景:開源模型和專有模型。

對於開源模型,用戶可以下載模型並在本地私有數據上運行。舉例來說,Worldcoin的“World ID”升級計劃(“ZKML”)需要處理用戶的生物特徵數據,如虹膜掃描,以創建每個用戶的獨特標識符(IrisCode)。在這種情況下,用戶可以在保護其生物特徵數據隱私的情況下下載IrisCode生成的機器學習模型,並在本地運行。通過創建零知識證明(ZKP),用戶可以證明他們已經成功生成了 IrisCode ,從而保證了推理的真實性,同時保護了數據隱私。重要的是,高效的ZK證明機制(如Modulus Labs開發的機制)在訓練機器學習模型時具有關鍵作用。

另一種情況是,當用於推理的機器學習模型是專有的時,情況會稍微複雜。因為在本地進行推理可能不是一個選項。然而,零知識證明可以通過兩種可能的方式來幫助解決問題。第一種方法是在將匿名化數據發送到機器學習模型之前,使用 ZKP 對用戶數據進行匿名化處理,正如前面在數據集創建案例中所討論的。另一種方法是在將預處理輸出發送到機器學習模型之前,對私有數據進行本地預處理。在這種情況下,預處理步驟隱藏了用戶的私有數據,使其無法重構。用戶可以生成 ZKP 來證明預處理步驟的正確執行,而模型的其他專有部分可以在模型所有者的服務器上遠程執行。這些示例用例可能包括能夠分析患者醫療記錄以進行潛在診斷的 AI 醫生,以及評估客戶私人財務信息以進行金融風險評估的算法。

通過 ZK 技術,Web3可以提供更高的數據隱私保護,使得 AI 在處理私有數據時更加安全可靠,同時也為隱私敏感領域的 AI 應用提供了新的可能性。

3. 保證內容真實性,打擊深度偽造內容這類騙局

ChatGPT 的出現可能使人們忽略了一些專注於生成圖片、音頻和視頻的生成式人工智能模型。然而,這些模型目前已經能夠生成逼真的深度偽造內容。例如,最近流行的 AI 生成的寫真照片,以及模仿 Drake 新歌的 AI 生成版本,這些內容已經在社交媒體上廣泛傳播。由於人們天生傾向於相信所見所聽,這些深度偽造內容可能構成潛在的騙局危險。雖然一些初創公司試圖使用 Web2 技術來解決這個問題,但數字簽名等 Web3 技術可能更有效地解決這個問題。

在 Web3 中,用戶之間的交易由用戶的私鑰簽名以證明其有效性。類似地,文本、圖片、音頻和視頻內容也可以通過創作者的私鑰進行數字簽名,以證明其真實性。任何人都可以通過與創作者的公開地址進行簽名驗證,這個公開地址可以在創作者的網站或社交媒體賬戶上找到。 Web3網絡已經建立了所有必要的基礎設施來滿足這種內容驗證的需求。一些投資者已經將他們的社交媒體配置文件,如 Twitter,或去中心化社交媒體平台,如 Lens Protocol 和Mirror,與加密的公開地址相關聯,以增加內容驗證的可信度。例如,美國頭部投資機構 USV 的合夥人 Fred Wilson 討論了將內容與公共加密密鑰相關聯如何在打擊虛假信息方面起到作用。

儘管這個概念看起來很簡單,但要改善身份驗證過程的用戶體驗還需要很多工作。例如,內容的數字簽名過程需要自動化,以便為創作者提供無縫、流暢的體驗。另一個挑戰是如何在不需要重新簽名的情況下生成已簽名數據的子集,例如音頻或視頻片段。目前,許多項目都在努力解決這些問題,並且 Web3 在解決這些問題方面具有獨特的優勢。通過數字簽名等技術, Web3 有望在保護內容真實性和打擊深度偽造內容等方面發揮關鍵作用,從而提高用戶的信任和網絡環境的可信度。

4. 專有模型的信任最小化

Web3 技術還可以在專有機器學習(ML)模型作為服務提供時,實現最大程度地減少對服務提供商的信任。用戶可能希望驗證他們所付費購買的服務,或獲得關於ML模型公平執行的保證,即相同的模型用於所有用戶。零知識證明(ZKP)可以用於提供這些保證。在這個架構中, ML 模型的創建者生成一個代表 ML 模型的 ZK 電路。然後,在需要的時候,使用該電路為用戶的推理生成零知識證明。這些證明可以發送給用戶進行驗證,也可以發佈到負責處理用戶驗證任務的公共鏈上。如果 ML 模型是私有的,獨立的第三方可以驗證所使用的 ZK 電路是否代表該模型。在模型的執行結果具有高風險的情況下,這種信任最小化的方法尤其有用。以下是一些具體的用例:

醫療診斷的機器學習應用

在這種情況下,患者將自己的醫療數據提交給 ML 模型進行潛在的診斷。患者需要確保目標機器學習模型沒有濫用他們的數據。推理過程可以生成一個零知識證明,用於證明 ML 模型的正確執行。

貸款信用評估

ZKP可以確保銀行和金融機構在評估信用價值時考慮了申請人提交的所有財務信息。此外,通過證明所有用戶使用相同的模型,ZKP可以證明公平性。

保險理賠處理

當前的保險理賠處理是手動和主觀的。然而,ML 模型可以更公平地評估保險單和索賠細節。與 ZKP 相結合,這些索賠處理 ML 模型可以被證明考慮了所有保單和索賠細節,並且同一模型用於處理同一保單下的所有索賠。

通過利用零知識證明等技術,Web3 有望為專有 ML 模型的信任問題提供創新的解決方案。這不僅有助於提高用戶對模型執行的信任,還能夠促進更加公平和透明的交易過程。

5. 解決模型創建的集中化問題

創建和訓練 LLM(大型語言模型)是一個耗時且昂貴的過程,需要特定領域的專業知識、專用的計算基礎設施以及數百萬美元的計算成本。這些特徵可能會導致強大的集中實體,例如 OpenAI ,它們可以通過控制對其模型的訪問來對其用戶行使重大權力。

考慮到這些集中化風險,關於 Web3 如何促進。創建不同方面的去中心化的重要討論正在進行中。一些 Web3 倡導者提出了將去中心化計算作為與集中式參與者競爭的一種方法。這個觀點認為,去中心化計算可以是一種更便宜的替代方案。然而,我們的觀點是,這可能不是與集中式參與者競爭的最佳角度。去中心化計算的缺點在於,由於不同異構計算設備之間的通信開銷, ML 訓練可能會慢10到100倍。

一種方法是通過去中心化計算來分散模型創建的成本和資源。雖然有人認為去中心化計算可能成為替代集中式實體的更便宜方案,但通信開銷問題可能會限制其效率。這意味著在涉及大規模計算任務時,去中心化計算可能導致訓練速度減緩。因此,在尋求解決模型創建集中化問題時,需要仔細權衡去中心化計算的利弊。

另一種方法是採用 Proof of Private Work(PoPW)的方式來創建獨特而具有競爭力的 ML 模型。這個方法的優勢在於它可以通過將數據集和計算任務分散到網絡的不同節點來實現去中心化。這些節點可以為模型訓練做出貢獻,同時維護各自的數據隱私。 Together 和 Bittensor 等項目正在朝這個方向發展,試圖通過 PoPW 網絡來實現模型創建的去中心化。

人工智能代理的支付和執行軌道

人工智能代理的支付和執行軌道在最近的幾周中引起了極大的關注。使用LLM(大型語言模型)來執行特定任務並實現目標的趨勢不斷上升,這一潮流起源於BabyAGI的概念,並迅速擴散至高級版本,包括AutoGPT等。這引發了一個重要的預測,即在未來,人工智能代理將在某些任務中表現出色並變得更加專業。如果出現了專門的市場,人工智能代理就有能力搜索、僱用和支付其他人工智能代理的費用,從而協同完成重要項目。

在這一進程中,Web3 網絡為人工智能代理提供了理想的環境。特別是在支付方面,人工智能代理可以配置加密貨幣錢包,用於接收付款並向其他代理付款,實現任務分工和合作。除此之外,人工智能代理還可以無需許可地委託資源,將其插入加密網絡。例如,如果一個人工智能代理需要存儲數據,他們可以創建一個Filecoin錢包,支付去中心化存儲網絡IPFS上的存儲費用。另外,人工智能代理還可以委託去中心化計算網絡(如Akash)的計算資源,以執行特定任務,甚至擴展其執行範圍。

防止AI侵犯隱私

然而,在這一發展過程中,隱私和數據保護問題變得尤為重要。鑑於訓練高性能機器學習模型需要大量數據,因此可以安全地假設任何公共數據都會進入機器學習模型,這些模型可以使用這些數據來預測個人的行為。特別是在金融領域,建立機器學習模型可能導致用戶財務隱私受到侵犯。為了解決這個問題,一些隱私保護技術如 zCash、Aztec支付,以及Penumbra和Aleo等私人DeFi協議可以用來確保用戶的隱私得到保護。這些技術可以在保護用戶數據的同時進行交易和數據分析,從而實現金融交易和機器學習模型開發的平衡。

結論

我們相信 Web3 和 AI 在文化和技術上是相互兼容的。與 Web2 中對機器人的抵觸情緒不同,Web3 憑藉其無需許可的可編程性質,為人工智能的蓬勃發展創造了機會。

從更宏觀的角度來看,如果將區塊鏈視為一個網絡,那麼人工智能有望在這個網絡的邊緣發揮主導作用。這一觀點適用於各種消費應用程序,從社交媒體到遊戲。迄今為止,Web3 網絡的邊緣主要由人類組成。人類會發起並簽署交易,或者通過預先設定的策略讓機器人代表他們採取行動。

隨著時間的推移,我們可以預見網絡邊緣會出現越來越多的人工智能助理。這些 AI 助理將通過智能合約與人類以及彼此互動。我們相信這些互動將帶來全新的消費者和用戶體驗,可能會引發創新的應用場景。

Web3 的無需許可特性賦予了人工智能更大的自由度,可以更緊密地與區塊鍊和分佈式網絡集成。這有望促進創新、擴展應用領域,並為用戶創造更富有個性化和智能化的體驗。同時,需要密切關注隱私、安全和倫理問題,以確保人工智能的發展不會給用戶帶來負面影響,而是真正實現技術與文化的和諧共存。