“人類永遠不會嫌網絡太快,就像永遠不會嫌高鐵太快,你只會嫌它慢,希望它更快些。”

一個月內,百度、阿里、騰訊、商湯、訊飛、360等國內大廠扎堆發布“中國版GPT ”,這家的名字還沒記清楚,另一家的又蹦了出來,一時間AI 大模型“諸神混戰”。可實話實說,和ChatGPT 相比,國內的GPT 還存在一定差距,但大家對於AI 的狂熱渴求已經被點燃,越來越多的企業意識到, AI 這班車,再不上,就來不及了。

大語言模型的成功與挑戰

以GPT 系列模型為代表的大語言模型成為近來最受關注的技術之一。

圖| OpenAI-ChatGPT

ChatGPT 憑什麼落別人那麼遠?

模型越大, AI 回饋的效果越好。 OpenAI 的GPT-1 模型有50億個參數, GPT-3.5 有1750億個參數,到現在的GPT-4 預計將有超過一個T的參數。可以看出參數是成倍甚至成指數級增長。這種增長模型的變化,首先對內存性能有著極高要求,因為訓練它需要海量數據,同時需要處理海量數據集;此外,是數據中心的計算能力,還有GPU 與CPU 之間的通信;更重要的是網絡的帶寬,這些因素將決定大語言模型的整體性能。

整體性能決定了大模型運行、訓練所需的時長,也決定了對大模型後續調優再訓練的周期。比如你的大語言模型訓練需要6個月,一年可能最多訓練2次,而別人訓練只需要2或3個月,一年就可以訓練多次,那麼最後AI 的迭代效果是完全不一樣的。

圖| NVIDIA

如今,不只是提出大語言模型的公司,越來越多的企業已經意識到AI 可能會優化工作流程或是給客戶提供相應的服務,大家紛紛開始嘗試做自己的產品。但一旦大家都在這個模型的基礎上去做,就會遇到吞吐量和性能的瓶頸。要支撐這麼一個大模型做訓練,投入成本是非常高的。

圖| NVIDIA

此外還有電力的限制,能做大模型訓練的數據中心的功耗和電力需求是非常大的,且增長趨勢明顯。數據顯示,數據中心一年消耗電力200 T瓦時,也就是2000億度電,佔全球電力使用量的2%。 2000億度電是什麼概念? 2021年我國三峽水電站發電量為1036億度,也就是三峽水電站兩年發的電量才夠全球數據中心用一年。而隨著AI 數據中心的部署和持續增長,到2030年,全球電力使用的預測份額將達到5%,這將為全球能源、環保、碳排放等帶來巨大挑戰。

你跟ChatGPT可能只差了一個DPU

在AI 的競賽中,有兩種方式:第一種是用資源去堆,就像造車一樣,後造車的永遠要比先造車的人燒更多的錢去打市場;第二種是在同等資源下,比誰快,快就需要效率,而提高效率就需要DPU 。

微軟此前發布的博客透露了OpenAI 的ChatGPT 採用的硬件是基於NVIDIA 智能網卡和InfiniBand 200G 網絡所做的產品,未來也有意部署DPU 。

圖| 微軟官博

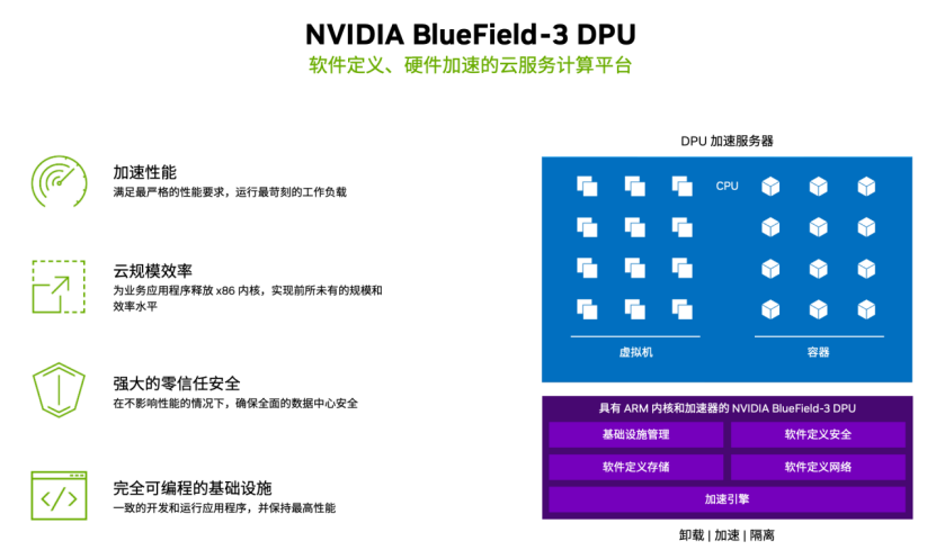

而為了應對AI 模型訓練、推理帶來的需求和挑戰, NVIDIA 近日發布了其最新一代數據處理器BlueField-3 DPU ,並宣布全面量產。

圖| NVIDIA

NVIDIA 創始人兼首席執行官黃仁勳先生表示, AI 時代需要雲數據中心基礎設施來支持非凡的計算需求。 “ NVIDIA BlueField-3 DPU 實現了這一進步,將傳統的雲計算環境轉變為加速、節能和安全的基礎設施,以處理生成AI 的苛刻工作負載。”

據NVIDIA 介紹, BlueField-3 DPU 是一款專為數據中心設計的、軟件定義、硬件加速的雲服務計算平台。它集成了高達16個計算核心,可提供高達400Gbp/s的網絡帶寬,並且支持多種協議和功能,包括網絡虛擬化、彈性負載均衡、數據中心互連等。 BlueField-3 DPU 還擁有世界領先的存儲加速功能,可提供高達1.6Tbp/s的存儲帶寬,並支持NVMe-over-Fabric 和RDMA 等高性能存儲協議。

大語言模型背後的硬件構成是怎樣的?各家都不同。以NVIDA DGX 為參照,支持大語言模型的服務器由8顆NVIDIA 高性能GPU 、4個NVIDIA NVSWITCHES 、2顆x86 CPU、9塊NVIDIA BlueField-3 DPU 、2T DDR5內存、PCIe Gen5.0,以及服務器間的NVIDIA Quantum-2 InfiniBand 網絡構成。

其中NVIDIA BlueField-3 DPU 發揮了怎樣的作用?首先是加速性能:NVIDIA BlueField-3 DPU 具有豐富的硬件加速器,可以滿足大語言模型嚴格的性能要求,並運行苛刻的工作負載;其次,雲規模效率:NVIDIA BlueField-3 DPU 可以釋放CPU 核心,使大語言模型應用具有更好的性能和可擴展性,提升服務器的效率和能效,降本增效;第三是強大的零信任安全:安全的基礎設施都可以運行在NVIDIA BlueField-3 DPU 之上,並基於此構建零信任安全模型,在不影響性能的情況下,確保數據中心安全;第四是完全可編程的基礎設施:NVIDIA DOCA 2.0 體現了NVIDIA BlueField-3 DPU 的軟件可編程性,借助NVIDIA BlueField-3 DPU 可以獲得完全可編程的加速數據中心平台。

圖| NVIDIA

簡單地說,NVIDIA BlueField-3 DPU 可以提升整個網絡性能,配合高算力GPU ,可以支撐更大規模的大語言模型訓練,從而縮短訓練時間。根據模型需求動態調整部署以共享算力資源,並應對不同規模的模型訓練;提升服務器能效、釋放算力資源,用更少的服務器完成更多的任務,從而幫助企業實現節能環保、降本增效。

據NVIDIA 介紹,大語言模型和生成式AI主要會構建在雲基礎設施之上,以雲服務的方式服務於市場,因此,DPU 會主要應用於雲服務提供商、AI 技術公司以及採用AI 技術的企業。據悉,NVIDIA BlueField-3 DPU 已經在部分國內公有云服務提供商進行測試,後續會逐步開始採用。

在不久前的GTC 2023 大會上,NVIDIA 創始人兼首席執行官黃仁勳先生堅定表示“ AI 迎來了' iPhone 時刻'”,回想當年蘋果手機剛問世,當時的用戶還都想著手機不就是用來打電話、發短信的?而今天,我們幾乎已經遺忘了當時的想法和其他手機。同樣,你會發現生活將慢慢被AI 改變。

*聲明:本文為MetaPost原創,如需轉載請聯繫我們。未經允許嚴禁轉載,文章版權及最終解釋權歸MetaPost所有。