审阅:0xmiddle

来源:内容公会 - 新闻

介绍

在快速发展的人工智能(AI)领域,确保 AI 推理结果的可信性和可验证性至关重要。传统的集中式 AI 系统通常缺乏透明度,容易受到篡改,从而削弱了信任。

Apus Network 通过利用设计来实现 AO 生态系统内的 Trustless AI 解决方案解决了这些挑战。该方法结合了 Arweave 的去中心化存储和 AO 的超并行计算,以提供可验证和可信的 AI 推理结果,为更可靠和透明的 AI 应用铺平了道路。

受 aos-llama 和 opML 的启发,我们设计了 Apus Network,详细介绍如下。

1. aos-llama 介绍

1. aos-llama 特性

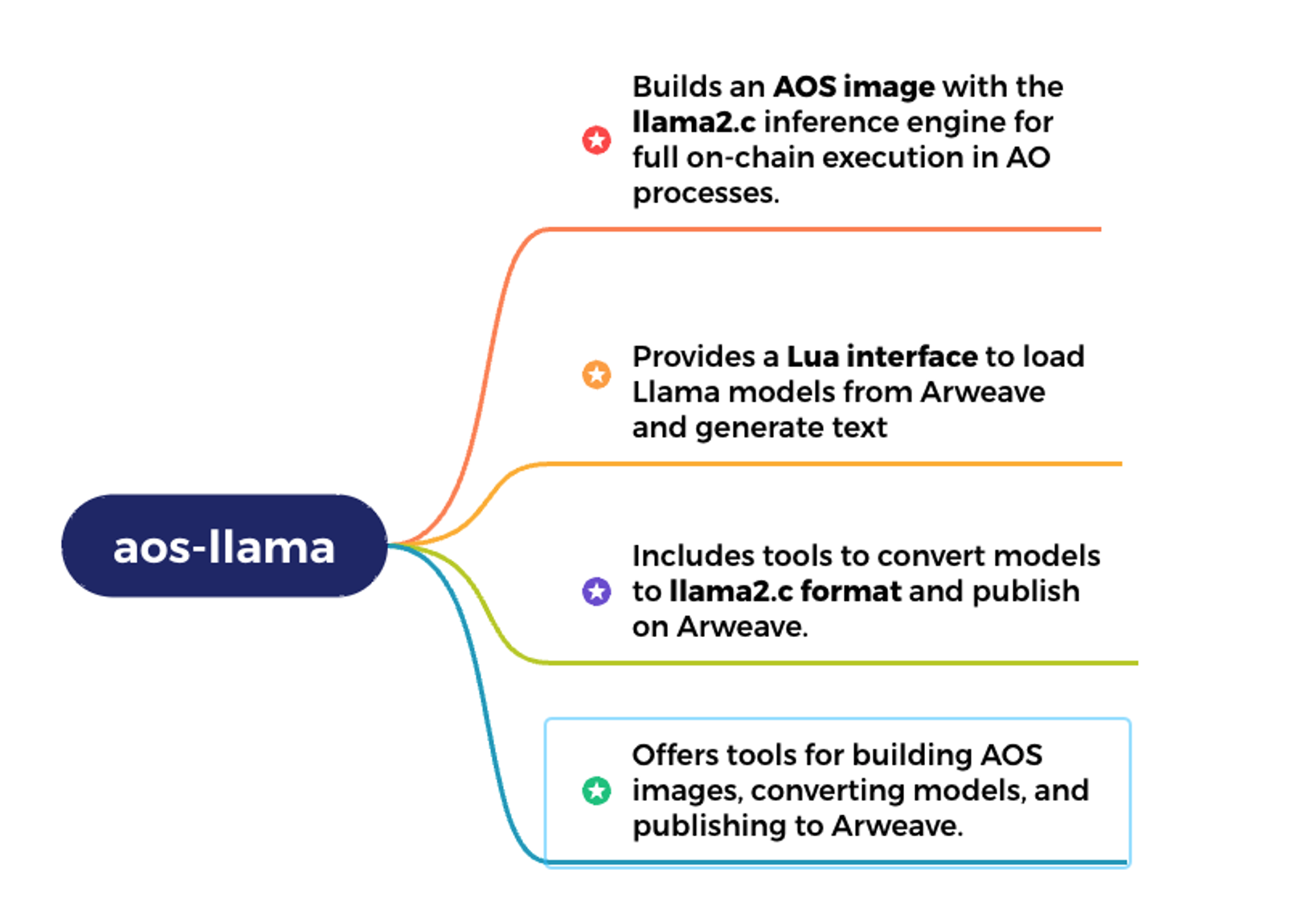

aos-llama 的主要特性如下:

1.构建 AOS 镜像:

- aos-llama 使用 llama2.c 推理引擎来构建 AOS 镜像,从而实现 AO 进程中的完全链上执行。

2.提供 Lua 接口:

- 它提供了一个 Lua 接口,可以从 Arweave 加载 Llama 模型并生成文本。

3.包含转换工具:

- aos-llama 包含将模型转换为 llama2.c 格式并发布到 Arweave 的工具。

4.提供综合工具集:

- 它提供用于构建 AOS 镜像、转换模型和发布到 Arweave 的工具。

这些特性使 aos-llama 能够高效地在 AO 上执行 AI 推理。

2. 技术架构图

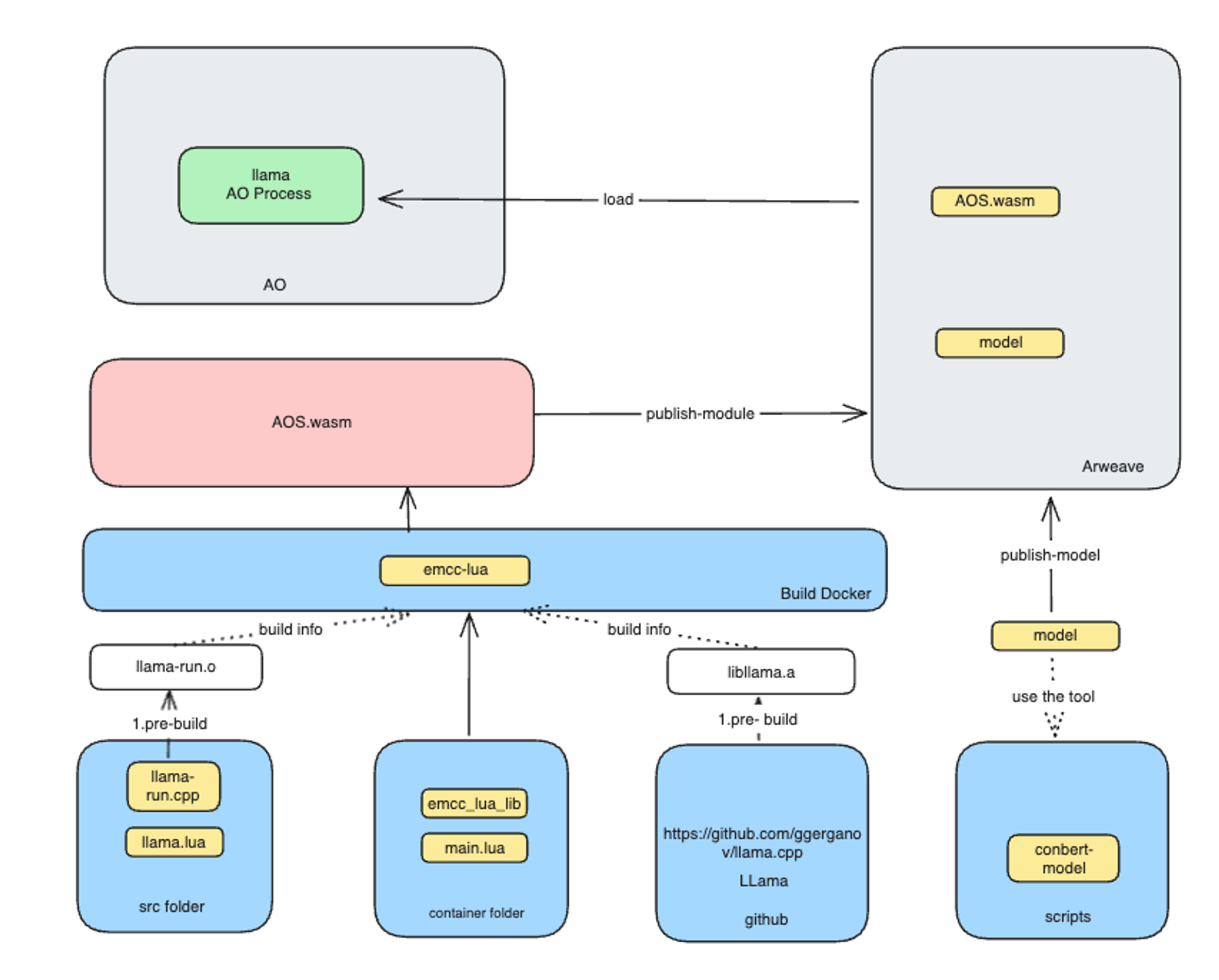

aos-llama 的技术架构可以分为以下几个主要部分:

1.Llama AO 进程:

在 AO 环境中,Llama AO 进程负责运行 Llama 模型。

2.AOS.wasm:

这是一个发布到 Arweave 的 WebAssembly 模块。它使用 emcc-lua 工具构建。

3.构建 Docker:

- 构建过程在 Docker 容器中进行,使用 emcc-lua 生成 AOS.wasm。

- 容器包括必要的源代码和构建脚本,如 llama-run.cpp、llama.lua、emcc_lua_lib 和 main.lua。

4.模型转换和发布:

- 使用特定工具将模型转换为适当的格式并发布到 Arweave。

- 转换后,模型文件存储在 Arweave 上,准备由 AO 进程加载使用。

5.Arweave:

- Arweave 作为一个去中心化存储平台,存储 AOS.wasm 和模型文件。

- AO 从 Arweave 加载 AOS.wasm 和模型文件以执行AI推理任务。

详细过程:

预构建:

- 在 Docker 构建容器中,预构建步骤包括编译 llama-run.cpp 生成 llama-run.o 并从 GitHub 仓库获取 libllama.a。

构建 AOS.wasm:

- 使用 emcc-lua 工具,将预构建的 llama-run.o 和 libllama.a 结合生成最终的 AOS.wasm 文件。

发布到 Arweave:

- 生成的 AOS.wasm 和模型文件发布到 Arweave,供 AO 使用。

加载和执行:

- AO 从 Arweave 加载 AOS.wasm 和模型文件并执行 AI 推理任务。这实现了链上 AI 模型调用和可验证的 AI 推理结果。

这种架构确保了 AI 模型和推理过程的去中心化存储和验证,增强了系统的安全性和可靠性。

2. 什么是 Trustless AI?

Trustless AI 是指一个框架或系统,其中 AI 推理的结果是可信和可验证的,无需依赖中央权威或中介机构。这个概念确保 AI 模型的预测和输出是透明的、防篡改的,并且可以被任何一方独立验证。

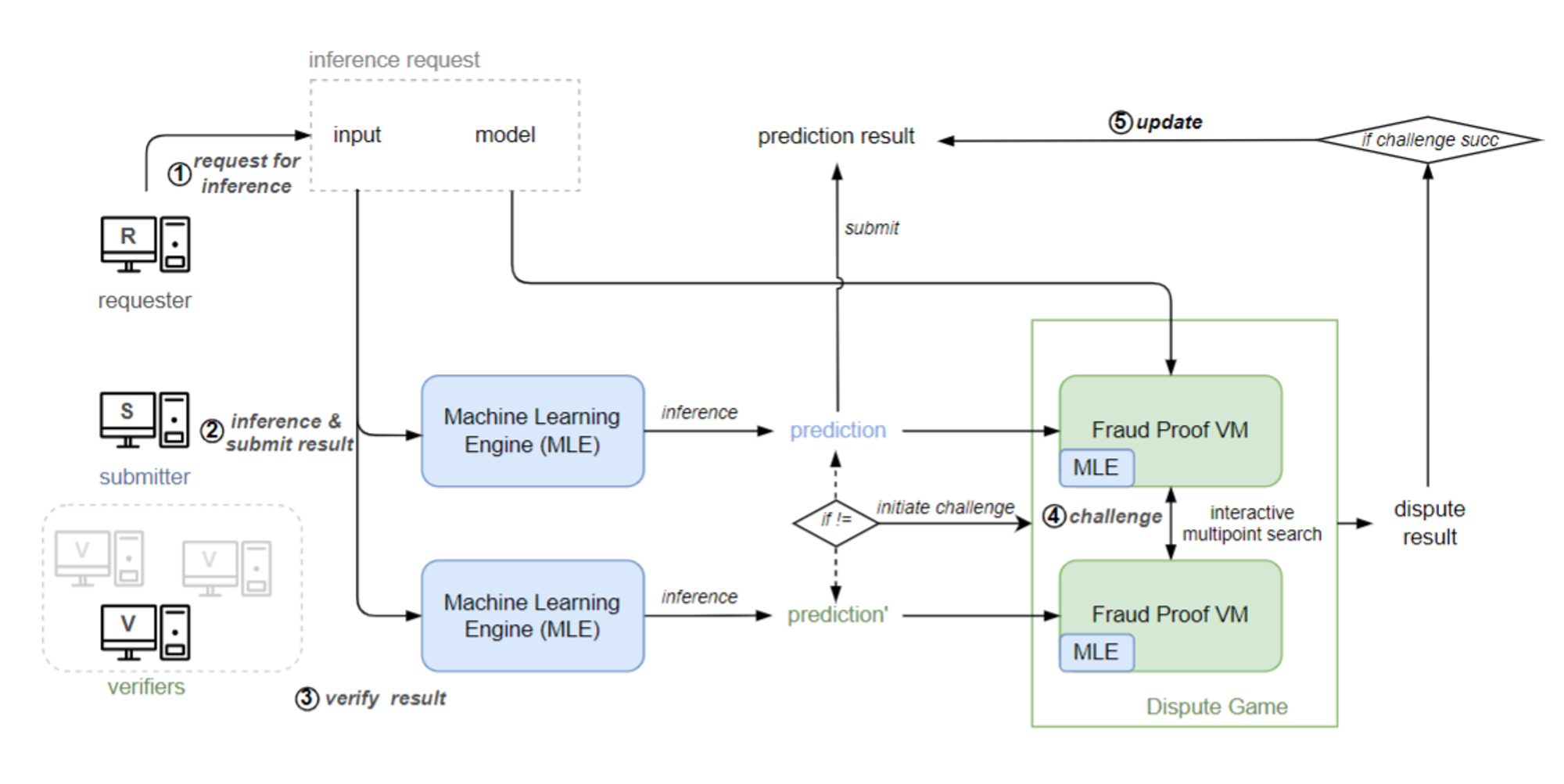

opML(Optimistic Machine Learning on Blockchain)是一种创新方法,它使用类似于乐观汇总系统的交互式欺诈证明协议,使区块链系统能够执行 AI 模型推理。基于 AO 和 Arweave 的架构,这可以很容易地实现。

3. Apus Network 的 Trustless GPU 解决方案,实现 AO 中的 Trustless AI

AO 的主要焦点是使用 WASM(WebAssembly)运行进程(智能合约),这些进程在 CPU 上执行,以提供确定性的计算结果。这种确定性对于智能合约的可验证性至关重要。

然而,基于 GPU 的计算是非确定性的,对传统区块链平台构成挑战。由于 Apus Network 并非专门为智能合约设计,因此它不需要被 WebAssembly(Wasm)的设计限制用于 AI 推理。基于 SCP 的设计,它可以在 AO 上实现 Trustless AI 的目标。

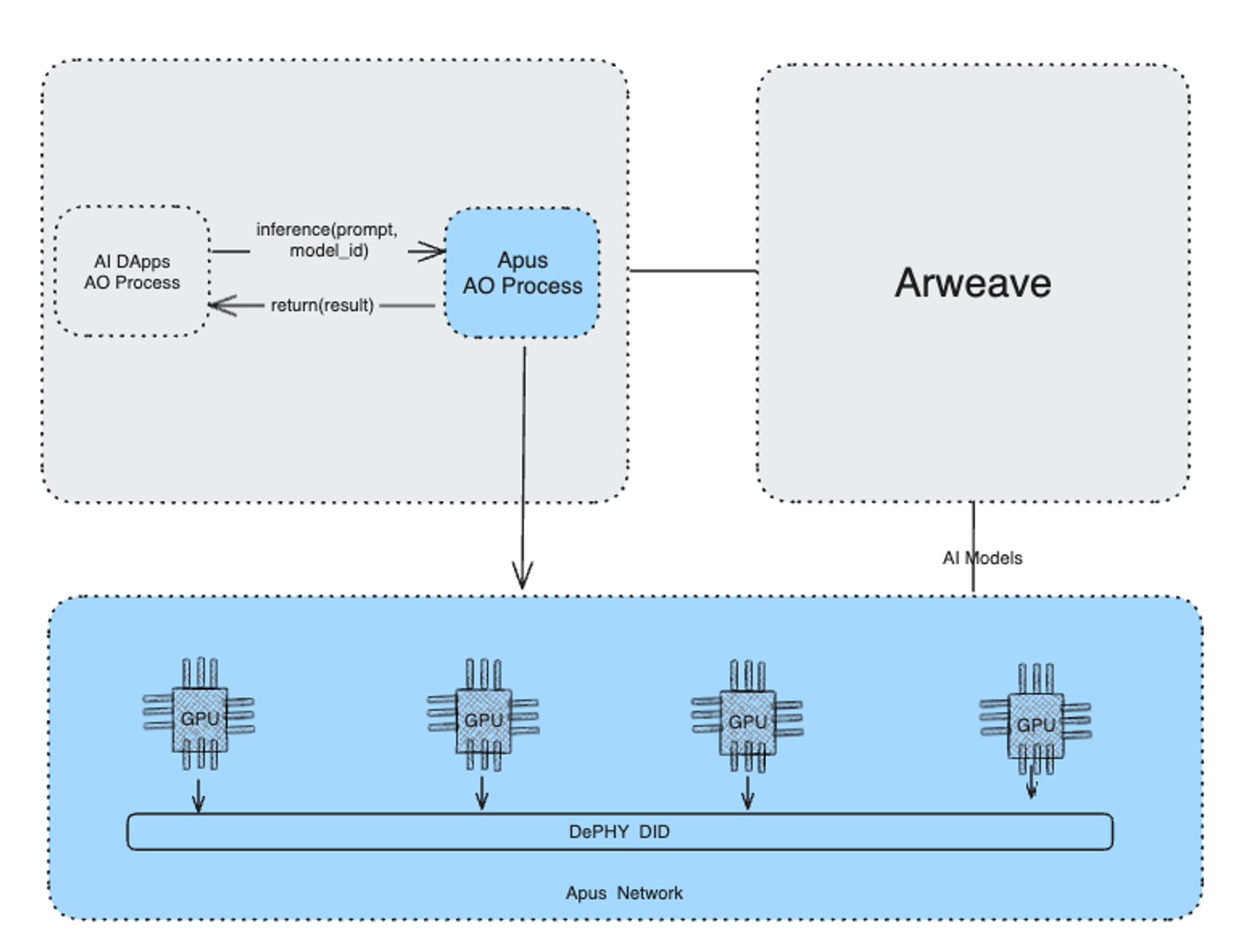

利用 AO 的超并行计算,Apus Network 的 Trustless GPU 网络被设计为安全、高效和可扩展的 AI 推理解决方案,为 Arweave 中的 AI 提供必要的计算能力,同时满足 Trustless AI 的三大支柱:GPU 完整性、AI 模型可信度和可验证的推理结果。该图提供了关键组件及其交互的概述。

组件和工作流程:

1.Apus AO 进程:

- 使用 AI 模型或 AI DApp 的 AO 进程开发人员可以开发他们希望的推理提示,并方便地从 Apus Network 官方文档中的支持模型目录中查询指定模型。这会触发一个 Apus AO 进程。AO 管理数据传输以及 AO 进程与 AI 模型之间的连接。

2.Arweave 存储:

- AI 模型存储在 Arweave 上,确保这些模型的不可变性和可用性。

- 每个存储在 Arweave 上的 AI 模型都有一个唯一的 ID,以便高效查询。这些模型通过 Ar.io 网关浏览器选择的网关从 GPU 网络发布到 Arweave 上。

3.GPU 网络:

- Apus Network 利用具有已建立完整性的 GPU 网络执行 AI 推理任务。

- 这些 GPU 通过 DePHY DID(去中心化物理设备标识)进行识别和管理,确保计算由受信任的硬件执行。

- Apus Network 基于 SCP 设计,确保所有程序、消息、AI 模型和日志都存储在 Arweave 上,保持结果的可信性和可验证性。

4.推理请求和结果验证:

- 该过程始于来自 AI DApp 或 AO 进程的推理请求,指定输入和模型 ID。

- Apus AO 进程管理数据传输,从 Arweave 查询指定模型。

- AI 推理在 GPU 网络上执行,结果返回给 Apus AO 进程。

5.安全性和可信性:

- 基于 SCP(基于存储的共识范式)的设计和 opML 的验证原则,实施 AI 推理结果变得非常简单。

- Apus Network 的设计基于 SCP,保证所有程序、消息、AI 模型和日志都存储在 Arweave 上,保持 AI 过程的可信性和可验证性。

6.成本管理:

- 计算成本由用户管理,他们可以自行执行计算或选择特定的网络节点执行。

- 这种灵活性允许用户优化其成本和性能需求。

结论

Apus Network 通过其 Trustless GPU 解决方案,为在 AO 生态系统中实现 Trustless AI 提供了一个强大的框架。通过结合 Arweave 的去中心化存储与 GPU 网络的完整性,Apus Network 确保 AI 推理结果是可验证、可信和透明的。这种创新方法不仅增强了 AI 应用的可靠性,还为各种去中心化平台中的 AI 集成提供了更安全和高效的途径。